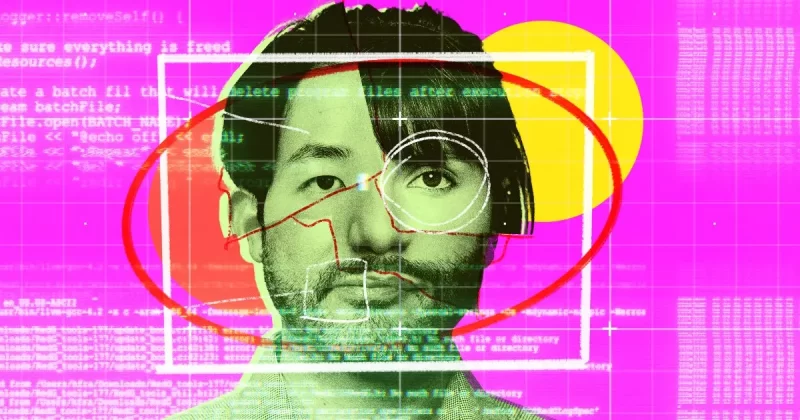

Искусственный интеллект признан ненадежным для использования в полиции

В свете недавних событий, связанных с использованием ИИ в расследовании убийства в Кливленде, возникает вопрос о потенциальной угрозе превращения нашего общества в жестокую техноутопию. Несмотря на то, что эта опасность еще не стала реальностью, произошедшее заставляет задуматься о границах доверия к технологиям и о необходимости их этического регулирования.

В ходе расследования убийства 33-летнего Блейка Стори в феврале 2024 года полиция Кливленда прибегла к помощи ИИ для идентификации подозреваемого. Для этого они использовали Clearview — платформу распознавания лиц, вызывающую споры. На основании данных, полученных с помощью ИИ-системы Clearview, полиция получила ордер на обыск и арестовала Кейона Толберта. Однако судья отклонил все доказательства, полученные с помощью ИИ, сославшись на их ненадежность.

Этот случай демонстрирует опасность слепой веры в технологии. Компания Clearview, несмотря на предупреждение о возможной неточности своих продуктов, активно продвигает свои услуги правоохранительным органам. Более того, расследование Washington Post показало, что по меньшей мере восемь американцев были ложно арестованы на основании данных распознавания лиц. При этом все арестованные оказались чернокожими.

Этот факт указывает на потенциальную дискриминационность таких технологий и необходимость тщательного изучения их влияния на различные социальные группы. История с расследованием убийства в Кливленде служит предостережением о важности баланса между технологическим прогрессом и защитой гражданских свобод. Необходимо разработать строгие этические нормы и юридические рамки для использования ИИ в правоохранительной деятельности, чтобы избежать превращения нашего общества в техноантиутопию.

А вы знаете, что крысы оказались умнее продвинутого ИИ?