Новейшие технологии позволяют достигать почти фантастических целей при грамотной реализации. К сожалению, иногда они оказываются не в тех руках и используются далеко не с благими целями. Мошенники заняли лидирующие позиции в освоении возможностей искусственного интеллекта. С его помощью они создают крайне реалистичные фотографии, видеозаписи и аудиодорожки, способные сбить с толку кого угодно. Однако, распознать фальшивый контент все же можно. Эксперты советуют быть внимательным и тщательно анализировать детали, которыми мы обычно пренебрегаем.

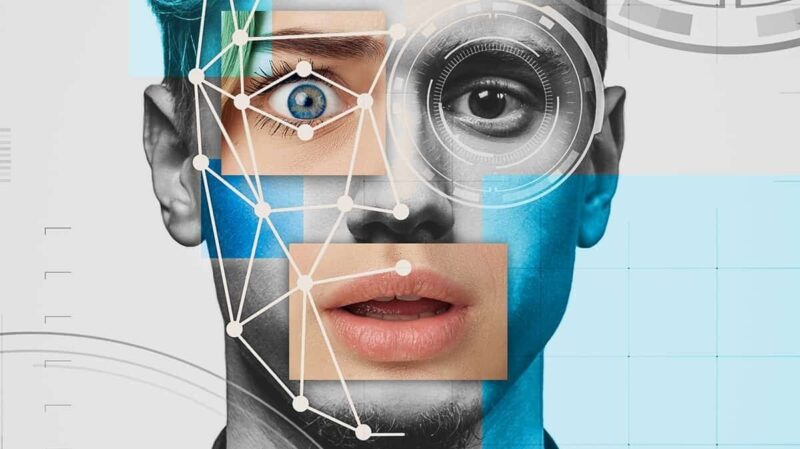

Безусловно, специальный софт выполнит эту работу точнее, но распознавание дипфейков возможно и «в ручном режиме». Стоит обратить внимание на предлагаемое качество картинки. Мошенники, как правило, оставляют его невысоким, чтобы скрывать артефакты и дефекты обработки. Также стоит внимательно посмотреть на лица людей. Некоторые детали могут выдать подделку – выражение лица и мимика, цвет кожи и волос, хаотичные движения глаз и слишком частое моргание. Нужно обращать и на голоса. После ИИ-обработки они могут иметь странную эмоциональную окраску.

Дипфейки могут «доставляться» обывателям в качестве голосовых звонков от родственников, нуждающийся в помощи. При малейших сомнениях следует немедленно прервать общение и перезвонить близкому человеку самостоятельно. Также мошенники генерируют видеоролики, где лидеры мнений мотивируют людей на определенные действия. Это может быть голосование или розыгрыш ценных призов. К любому такому видео нужно подходить критически, а не верить безоговорочно. Помните, что главной целью было и остается выманивание денег и личных данных. Будьте внимательны к деталям и вас никто не сможет обмануть!

Удивительно, но уголовная ответственность за создание дипфейков отклонена правительством РФ.